Edition 2022 - Big Data Technology Warsaw Summit

Interview: Microsoft

Interview: Vertica

BDTWS 2022: o trendach, nowościach i wszystkim, co najbardziej aktualne w świecie wielkich danych

Sztuczna inteligencja, streaming danych i analityka w czasie rzeczywistym, architektura i inżynieria danych, a wszystko to oczywiście we wszechogarniającej chmurze - po dwóch latach przerwy eksperci od danych z całego świata ponownie spotkali się na organizowanej przez Evention oraz GetInData konferencji Big Data Tech Warsaw Summit. W odróżnieniu od poprzedniej imprezy zrealizowanej w formule stricte online, tegoroczna, ósma edycja miała charakter hybrydowy – tradycyjnej, odbywającej się w warszawskim hotelu Crowne Plaza konferencji towarzyszyły warsztaty i dodatkowy dzień konferencyjny online.

„Od poprzedniego spotkania na tradycyjnej konferencji minęły 2 lata. To dużo czasu. W tym okresie zmieniło się wiele rzeczy na świecie, zmienił się także krajobraz Big Data. Pojawiły się nowe hasła, dostrzegliśmy nowe trendy, zauważyliśmy nowe technologie i nowe firmy. Data mesh, cloud, data lakehouse, analytics engineering, Snowflake, dbt, Fivetran, Airbyte – o większości tych tematów, które zaczynają formować tzw. modern data platforms będziemy dyskutować na konferencji” - mówił Adam Kawa, CEO i współzałożyciel GetInData otwierając wspólnie z Przemysławem Gamdzykiem, CEO & Meeting Designer w Evention konferencję BDTWS 2022.

„Sztuczna inteligencja i uczenie maszynowe jest dzisiaj obecne wszędzie, w każdej branży, ale analizując wystąpienia na naszej konferencji dostrzegliśmy, że jest to najbardziej gorący temat w sektorze handlu detalicznego oraz e-commerce. Oczywiście chmura obliczeniowa jest miejsce, w którym pojawiają się innowacje i realizowane są pionierskie projekty. Właśnie dlatego istniejące firmy powszechnie migrują do chmury a nowe organizacje zaczynają budować swoje rozwiązania w chmurze od pierwszego dnia swojego istnienia. Coraz częściej widać także, że pozyskiwanie danych w czasie rzeczywistym odbywa się przy wykorzystaniu odpowiednich technik audytu i zapewniających wysoką jakość danych. Wreszcie dostrzegamy także, że im więcej mamy danych tym bardziej odczuwamy potrzebę wdrożenia rozwiązań do odkrywania danych oraz potrzebę nowego podejścia do dostępu do danych oraz kwestii odpowiedzialności i własności danych” - dodawał Adam Kawa.

Na konferencji Big Data Tech Warsaw Summit 2022 wystąpiło ponad 70 ekspertów zajmujących się big data w organizacjach wykorzystujących dane do kształtowania swojej działalności. W swoich wystąpieniach pogrupowanych w osiem tematycznych ścieżek, skupiali się na różnorodnych aspektach pracy z danymi, opowiadali o najnowszych technologiach z praktycznego punktu widzenia oraz przedstawiali studia przypadków a później dyskutowali przy kilkunastu stolikach w ramach sesji roundtables. Hybrydowa konferencja przyciągnęła ponad 600 uczestników.

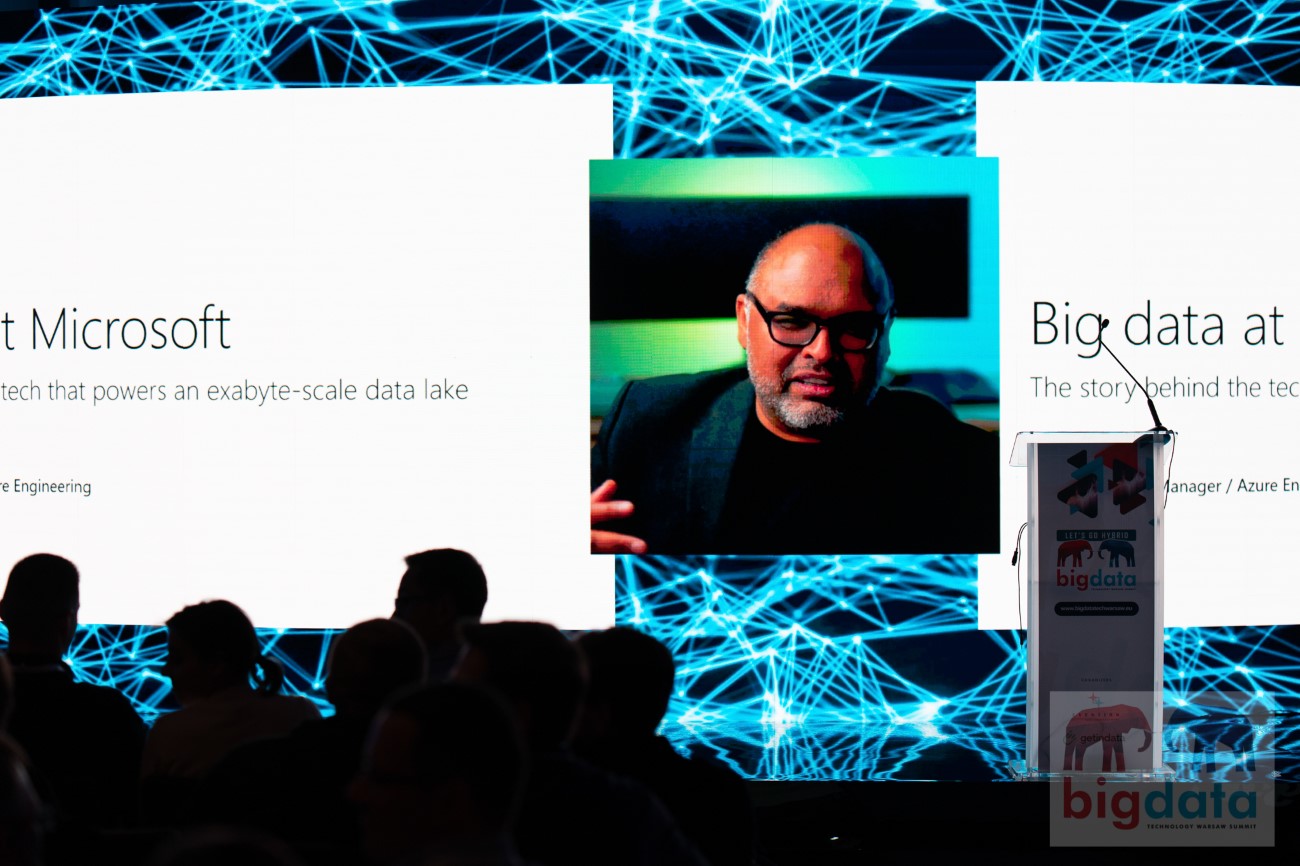

Skala ma znaczenie

W związku z tym, że mamy coraz więcej danych, zmuszeni jesteśmy do poszukiwania nowych technologii, które są w stanie poradzić sobie z skalą na poziomie exabajtów. Właśnie o tym opowiadał podczas swojego wystąpienia Saveen Reddy, Group Product Manager – Azure Engineering w Microsoft. Wykorzystywana w Microsoft platforma Cosmos Data Lake (nie należy mylić z Azure Cosmos DB) to łącznie blisko 250 tys. serwerów i 11 exabajtów danych. W prace z danymi zaangażowanych jest średnio miesięcznie 15 tys. unikalnych deweloperów. Cztery typowe scenariusze, które są realizowane to analityka logów usług, telemetria urządzeń, dane o klientach 360 oraz projekty kognitywne. Podczas swojego wystąpienia Saveen Reddy opowiadał o wykorzystywanych technologiach i strategii Microsoft w obszarze Big data, a także o tym jak pogodzić realia organizacji pracujących na ogromną skalę przy jednoczesnym utrzymaniu szybkiego tempa innowacji. Przedstawiał także wnioski z dotychczasowych doświadczeń i plany na przyszłość. Zwracał w szczególności uwagę na stosunek kosztów do efektywności, przekonując, że zawsze istnieją możliwości zrobienie więcej za mniej i otwierania nowych możliwości bez powiększania infrastruktury sprzętowej. Mówił o powszechnym wykorzystywaniu rozwiązań open source m.in. Spark, Python, Parquet i ORC a także integracji z Azure, w szczególności z HDInsight, Synapse i Data Factory.

„Niezwykle istotne jest przy tym wszystkim planowanie. Trzeba zawczasu pomyśleć o wszystkich kwestiach związanych z prywatnością danych i zgodnością z regulacjami prawnymi, a także jak będziemy monitorować, zarządzać i prognozować wskaźniki dotyczące kosztów i wydajności. W odniesieniu do inżynierii trzeba myśleć zwinności i wykorzystywać rozwiązania open source. Wreszcie ważne są także kwestie związane z kulturą wykorzystania danych w organizacji. Warto promować wykorzystanie danych, zachęcać do eksperymentów a wszystko to wspierać odpowiednimi narzędziami” – mówił Saveen Reddy.

Dane w praktyce

Jak zawsze na konferencjach BDTWS o wielkich danych opowiadają praktycy. Dzielą się swoimi przemyśleniami, podpowiadają innym jak zacząć stosować nowe technologie czy podejścia i czego się wystrzegać. Max Schultze, Data Engineering Manager w Zalando, występujący także podczas poprzednich edycji konferencji, opowiadał o data mesh w praktyce.

Data Mesh to mocny kandydatem do zastąpienia scentralizowanego data lake i hurtowni danych jako dominujących wzorców architektonicznych w dziedzinie danych i analityki. Promuje on koncepcję produktów danych skoncentrowanych na konkretnej dziedzinie, które wykraczają poza udostępnianie plików. Ostatecznym celem jest bowiem gwarancja jakości i potwierdzenie własności i odpowiedzialności za dane.

„Data Mesh to hasło, które słyszał dzisiaj chyba każdy, kto zajmuje się danymi. W rzeczywistości mało kto jednak wie co to jest. Data Mesh składa się z czterech filarów: myślenia produktowego o danych, zastosowania domenowej konstrukcji w odniesieniu do rozproszonych danych, platformowego myślenia w kontekście infrastruktury danych oraz sfederowanego ładu i zarządzania” – mówił Max Schultze.

„Jeśli myślimy o przyjęciu data mesh we własnej organizacji, to na początek warto pamiętać o trzech rzeczach: trzeba wziąć pod uwagę rożne perspektywy występujące w organizacji w odniesieniu do danych, należy tworzyć system zachęt i pokazywać korzyści płynące z nowego podejścia oraz zacząć od małego projektu, który z czasem ma szansę rozpowszechnić się w całej organizacji” – dodawał Max Schultze.

Z kolei Andrew Hedengren, Data Platform Architect w Kambi opowiadał o znaczeniu analityki danych dla funkcjonowania firmy, która dostarcza rozwiązania i usługi dla operatorów gier i zakładów hazardowych na całym świecie. Kambi, w oparciu o technologię Vertica, monitoruje i raportuje dane z ponad 150 źródeł dla ponad 425 użytkowników na całym świecie, zachowując zgodność z przepisami i GDPR. Andrew Hedengren opowiadał, w jaki sposób Vertica dostarcza scentralizowaną wersję prawdy dla "prostego i skalowalnego" rozwiązania.

Chmura, chmura, wszędzie chmura

Otwierając konferencję Adam Kawa mówił, że miejscem wszystkich innowacji jest chmura obliczeniowa. Nic więc dziwnego, że do chmury migrują zarówno użytkownicy jak i dostawcy technologii. Nie jest to jednak takie proste, jak mogłoby się wydawać. O różnych sposobach i zagrożeniach wiązanych z migracją platformy big data opowiadali eksperci Google Cloud Poland: Radosław Stankiewicz, Data SCE at Professional Services Organization oraz Michał Żyliński, Cloud Customer Engineering Manager. Zbierając doświadczenia z wielu projektów migracyjnych klientów, które wspierali pokazywali często występujące ograniczenia, dostępne podejścia oraz krytyczne ryzyka dla sukcesu. Przede wszystkim zachęcali oni klientów, żeby nie czekali zbyt długo, zanim zwrócą się o pomoc, ponieważ historia pokazuje, że wielu klientów prowadzi migracje zupełnie samodzielnie a później potrzebuje wsparcia, kiedy „jest już za późno”, „wystartowali z niewłaściwym MVP” albo „są w trakcie Proof of Concept”.

O „podróży” do chmury hybrydowej opowiadali także przedstawiciele dostawców technologii - Michał Gutowski, Solutions Engineer oraz Kiryl Halozhyn, Solutions Engineer w Cloudera. Oferowana przez firmę platfroma CDP Hybrid Cloud zapewnia klientom pełną swobodę wyboru w zakresie prywatnych i publicznych środowisk cloud, ale także wydajności i kosztów zarządzania, bezpieczeństwa i samoobsługi a także elastyczności i kontroli.

„Wizja Cloudera dla hybrydowej chmury danych to zbuduj raz, uruchamiaj, gdzie chcesz, w dowolnej chmurze. Zapewniamy klientom wolny wybór do przenoszenia istniejących lub przyszłych aplikacji, w tym strumieni, sekwencji przetwarzania, baz danych, przestrzeni roboczych i innych produktów, samych danych oraz użytkowników, w obie strony, pomiędzy centrum danych a wieloma chmurami, bez konieczności przepisywania kodu” – podsumowywali Michał Gutowski i Kiryl Halozhyn.